Un système avec plusieurs IA pour un NLP plus agile

Les limites de GPT ou BERT.

Au cours des dernières années, les LLMs (Large Language Models, comme BERT ou les modèles GPT successifs), avec les Transformers qui sont leur cœur technologique, se sont imposés. Pour aboutir à ces performances – incontestables sur la génération de texte –, la taille des modèles a grandi exponentiellement (GPT3 a 175 milliards de paramètres, soit ~800GB de VRAM !), ainsi que le volume de données nécessaire à leur entrainement (LLaMA a été entrainé sur 4,5TB de texte !). Le coût économique et environnemental pour entraîner ces modèles est prohibitif, et de nombreuses sources s’accordent pour dire que la prochaine génération doit être plus petite, plus agile.

NLU « human-like », avec 2 modèles d’IA successifs.

Et c’est précisément le besoin des entreprises pour la digitalisation de leur relation client : apprendre vite, sur des volumes raisonnables, en respectant la protection des données. Pour ce faire, avec OWI, nous avons un atout : plutôt qu’un LLM « monolithique », nous misons sur un système avec plusieurs IA, inspiré de la science linguistique et de la manière dont le cerveau humain traite le langage. Pour la « compréhension » (NLU), ce système est organisé autour de 2 IA : une IA linguistique (qui traite le langage naturel et produit l’ensemble des signes présents dans un message), et une IA contextuelle (qui interprète chaque signe et, tenant compte du contexte, en trouve la signification).

1 000 fois moins de paramètres : ML beaucoup plus rapide.

Cette séparation permet de réduire drastiquement la taille des modèles utilisés : au lieu d’un seul modèle avec 100 milliards de paramètres, on en combine deux qui ont chacun un ordre de grandeur de 100M de paramètres, sans perdre en complexité. L’autre intérêt est que ces deux modèles peuvent être entraînés successivement, ce qui facilite grandement leur cycle de vie (développement, mise en production, amélioration continue). Ci-dessous, on explique pourquoi l’utilisation des deux IA linguistique et contextuelle permet également de réduire le volume de données nécessaires à la spécialisation pour un contexte client précis, avec une nouvelle innovation « GM Transformer » qui mêle le modèle OWI à l’architecture des Transformers.

Zoom sur l’IA linguistique

Indexation linguistique.

L’IA linguistique d’OWI analyse le texte soumis pour produire des signes (appelés GM, pour « Groupe de Mots ») : chacune de ces signes correspond à un petit graphe reliant des mots entre eux. Par la suite, l’IA contextuelle (“Catégorisation”) exploite ces GMs et les transforme en données précises et structurées (ce fonctionnement n’est pas détaillé ici, car ce n’est pas nécessaire à la compréhension de « GM Transformer »). Données qui peuvent ensuite être utilisées pour trouver la meilleure réponse, ou pour alimenter d’autres applications (CRM, GED… etc).

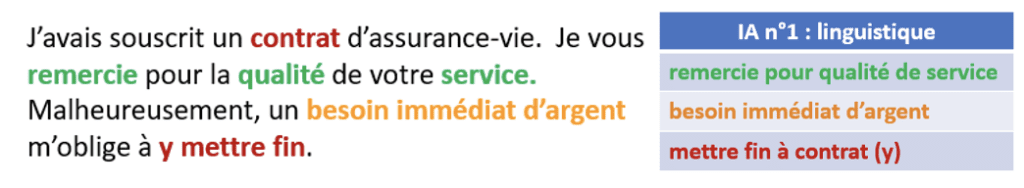

Illustration.

Ci-dessous, on donne l’exemple de quelques GM (tableau de droite) produits pour un message (à gauche). Le GM « besoin immédiat d’argent » correspond à un graphe reliant 4 mots : « besoin » et « immédiat », et aussi « besoin » « de » « argent ».

Le nombre de ces GM est beaucoup plus grand que le nombre de mots, mais l’intérêt est qu’il est possible d’associer directement à chacun une signification, et donc d’en déduire, plus facilement qu’à partir des mots, les données structurées utiles au métier : en moyenne, pour un message de 100 mots, on trouve 1 000 GMs, et seulement 12 données utiles. L’un des enjeux majeurs de l’apprentissage est donc de distinguer, parmi tous ces GMs, les plus utiles, et de prévoir, pour un contexte donné, les données qu’ils permettront de détecter. C’est la 1ère étape du Machine Learning de l’IA contextuelle.

GM Transformer

Modèle dédié à l’apprentissage.

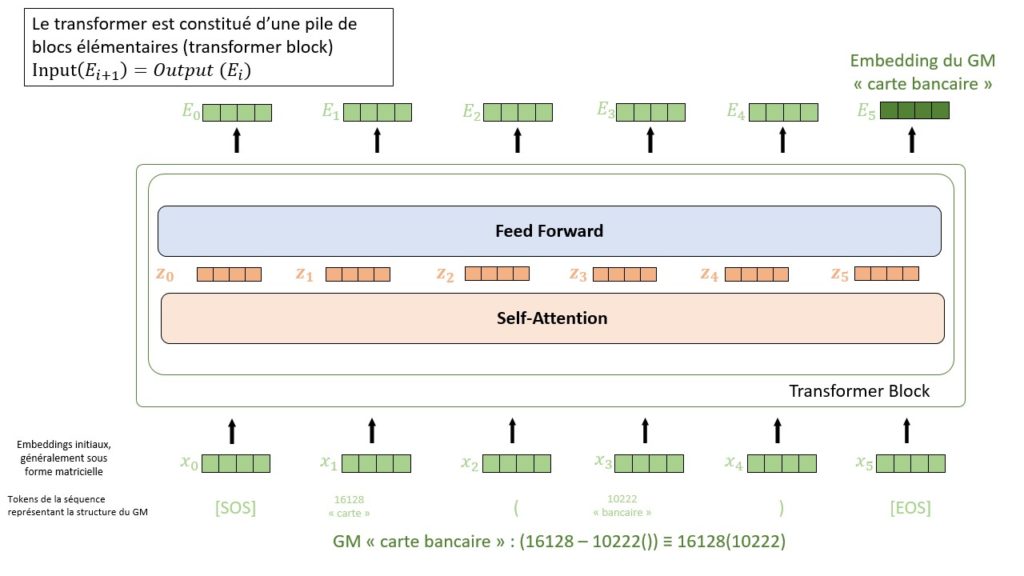

Pour faire le pont entre l’IA linguistique et l’IA contextuelle et entraîner cette dernière le plus efficacement possible, on utilise un modèle intermédiaire suivant l’architecture puissante du Transformer (Attention is all you need, 2017). Ce modèle a pour but d’améliorer l’entrainement de l’IA contextuelle :

- En augmentant la rapidité de mise en place pour un contexte client spécifique

- En facilitant la mise en place d’apprentissage en continu pour l’IA contextuelle

Masked Language Model (BERT).

Les données d’entrée du « GM Transformer » sont les GMs, que l’on représente sous forme d’une séquence de tokens, et on attend de lui qu’il produise une représentation vectorielle (« embedding ») qui permette notamment de discriminer entre les GM porteurs de sens et le bruit, que l’on peut alors exclure des traitements. L’objectif étant la représentation – et non la génération – on s’appuie sur la méthode d’entrainement éprouvée du « Masked Language Model », introduite par Google pour le modèle BERT (BERT: Pre-training of Deep Bidirectional Transformers for Language, 2018). Dans notre cas particulier, l’apprentissage est progressif :

- Un premier encodeur s’entraîne à reconstruire les GM, individuellement. Pour ce faire, on masque une partie du graphe identifiant un GM, et le modèle produit les tokens les plus susceptibles de s’y trouver. Ainsi, il développe une représentation des mots et de leurs interactions qui produisent les signaux sémantiques ;

- On utilise ce modèle pour initialiser une architecture encodeur-décodeur, dont la tâche d’entrainement est de reconstruire complètement un GM masqué, à partir des représentations des autres GM présents dans le contexte. On développe ainsi la représentation des GM en sortie de l’encodeur, notamment à partir de leurs cooccurrences ;

- Enfin, on peut utiliser des données annotées pour employer l’encodeur pré-entraîné à reconnaître les GM les plus importants dans un contexte client précis.

Premiers résultats.

La différence principale avec d’autres approches est évidemment la matière première : là où les LLM utilisent le texte brut en entrée du modèle, on utilise les signes linguistiques. Le premier modèle d’encodeur est ainsi beaucoup plus compact (90 millions de paramètres soit 2 000 fois moins que ChatGPT), car les séquences représentant les signaux sémantiques ne font que quelques tokens (10-20). Cela permet également de réduire le volume nécessaire à l’apprentissage. Dans nos premières expériences :

- On utilise du texte issu de Wikipedia pour le pré-entrainement du modèle (~3Go pour un modèle en anglais, et ~1,3Go pour un modèle en français).

- La spécialisation du modèle se fait en deux phases. Premièrement, on utilise un échantillon non annoté de messages pour raffiner le vocabulaire du modèle dans les messages qu’il devra traiter (100k mails dans notre cas, soit ~25Mo). Puis, on entraine le modèle sur sa tâche concrète avec les données annotées disponibles (entre 1 000 et 10 000 messages).

- Sur un premier jeu de test de 10k nouveaux messages, le modèle a déjà été capable de discriminer les GM entre les plus utiles et le bruit avec une précision de 95%, au-delà de ce que nous espérions.

R&D agile

Ces recherches sur GM Transformer accélèrent l’apprentissage automatique, sans modifier les 2 IA qui analysent les messages. Cela permet d’intégrer progressivement dans le produit OWI les résultats que nous obtenons, et de nous appuyer sur les retours d’expérience en fonctionnement réel. La 1ère mise à disposition de GM Transformer en production se fera avec la version 6.3, soit dès juillet 2023 !